「将来AIが多くの仕事を奪って多くの人は失業するだろう」

といった怪しい未来予測が様々なネットメディアやSNSで語られています。

私は、この手の未来予測には意味が無いと考えています。

AGIを実現する具体的方法論は見つかっていない

なぜなら、この手の話題で想定されるAIは、今実在しているChatGPTやo1, o3, Claude, Gemini と言った生成AIではなく、まだ実用化していないAGI(汎用人工知能)が登場した時の話をしているからです。

今のところ、AGIが登場する具体的予定はなく、一説には、現在の生成AIのコンピュータリソースを拡大しただけでは、AGIは実現出来ないと、多くのAI研究者や専門家が考えているという報道もあります。

「現在のAIをスケールアップしても汎用人工知能は開発できない」と考える科学者の割合は76%

確かにAI研究者の一部は、「あと5年から10年程度でAGIが実現する可能性は高い」というような意見を言っています。

しかし、これも何か確かな根拠があって言っているわけではないと思います。

現在の時点では、「AGIを実現する可能性は未知数である」というのが真実でしょう。

少なくとも生成AI高性能化の果てにはAGIは無いと言えます。

なぜAI技術的失業を煽るのか

「AIで今の仕事がなくなり多くの人が失業するぞ」と煽るタイプの人々には、いくつかの種類がいると思います。

ざっとSNS等に見る限り、「経営者・管理職」「委託業務の発注側」「社会に何らかの不満を抱えていて革命的変革を求めている人」の三種類に分類できると思われます。

経営者・管理職タイプ

このタイプの人々は、人を雇う側の立場で、AIによる自動化をダシにして、労働者全般に「お前らの代わりはいくらでもいるぞ」と脅しをかけて、労働者を騙して易くこき使おうとしているだけだと思われます。

ちょうどブラック企業の経営者と同じようなものでしょう。

実際にブラック企業の経営者なのかも知れません。

委託業務の発注側

これもブラック企業の経営者タイプと同じで、現在外注している委託業務について、AIをダシにして安く買い叩こうとしているだけでしょう。

今のところAIによる技術的失業は起こっていないので、AIによる自動化や省力化で仕事が減少する状況にはなっていません。

そもそもAIの活用方法を多くの企業が試行錯誤している段階で、AIによる自動化で従業員の解雇が進む状況には至っていません。

Claude3.7に、最近のIT人材の需給バランスについて質問した

米国では少しそれに近い話も聞こえてきますが、小規模な話で、失業者が増えるほどでは無いです。

SalesforceのCEOが「AI導入が成功したので今年はエンジニアを雇わない」と発言

セールスフォースも「今年は新規のエンジニアを雇わない」と言っているだけで、雇用しているエンジニアを解雇しているわけでも無さそうです。

解雇に関しては24年に1000人解雇して、別に1000人雇うという状況で、AIによる技術的失業とは言えないでしょう。

23年に7000人解雇しているとの事ですが、これは生成AIが登場したばかりの時期ですので、生成AIとは関係ないはずです。

このアピールもセールスフォースの新製品であるAIエージェント製品のコマーシャルアピールである可能性が高いと思います。

企業の商業アピールを額面通りに受け止めない方が良いでしょう。

社会に何らかの不満を抱えていて革命的変革を求めている人

例えば「誰でもAIでプログラムを作れるようになるので、もうITエンジニアは必要無い」と言っている人の過去の発言を遡ってみると、だいたい仕事でITエンジニアに不満を表明している人が多いです。

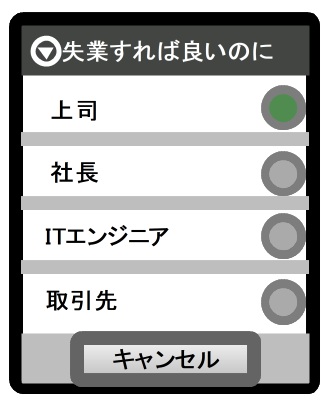

「AIで⚪⚪な人は失業する」と言っている人の少なくない人々は、その⚪⚪な人々に恨みを持っていて、社会的に排除したいという願望を持っているように見えます。

誰でも社会には敵の一人や二人は居ますし、違法行為の蔓延している業界は少なくないので、そういう⚪⚪に対する憎悪の感情があること自体は否定しません。

しかし、その⚪⚪がAIにより失業するという話は、信頼できる根拠に基づいた話ではないので、聞き手はスルーしておくのが賢明でしょう。

嫌いな人達からは転職するなりして、物理的に離れるのが賢明です。

インチキな話は無視するのが賢明

AIが長期的に社会の構造に大きな変革をもたらすことは、確実だと思いますが、それが進展するには、思ったより時間がかかると思います。

インターネットやスマホの普及には、それが登場してから10年以上の時間がかかっています。

新しい技術を社会で導入するには、それを使う側が「技術の使い方」を試行錯誤して生み出さなければなりません。

インターネットが登場した当初は、セキュリティや著作権保護などに問題が多く、実用的な使い方はできませんでした。

ファイル交換ソフトによる違法コピーで音楽業界が壊滅的被害を受けたことも記憶に新しいところです。

その後SSLや暗号化の補助的技術が発達して、法律の整備なども進み、ようやくインターネットが実用的な物になってきたわけです。

生成AIもまだ問題が多く、その能力を生かせる補助的技術も存在しません。 著作権などの法律の整備も始まったばかりです。

今の状況で、「直ちに生成AIを一般社会の中核業務に導入することは難しい」と考えるのが、現実的な考え方だと私は思います。

今後は、インターネットのSSLや暗号技術のように、生成AIを実用的にする補助技術が次々と開発されていくと思われます。

それがどんな技術になるかは分かりませんが、今のままの生成AIでは、使い難いのは事実です。

従って、今の生成AIが直ちに産業構造を大きく変えて、多くの人々が技術的失業する将来が訪れるのは、しばらく先のことになると思います。

むしろ、今は従来型のIT製品やサービスがようやく普及してきて、事務職や印刷業の雇用が急減しています。

インターネットとスマホによる技術的失業が、今ようやく起きているのが現実です。

AIの影響は10年以上先になると思います。

インチキなAI技術的失業を煽る言説は、無視して良いと私は思います。

それを語る人がいくら著名な人物であっても、話半分に聞いておくのが無難でしょう。

現在の生成AIの欠点

現在の生成AIには、いくつか欠点があります。 Claude 3.7 Sonnet にLLMの欠点を聞くと以下のように回答します。

LLMの欠点

LLM(大規模言語モデル)の具体的な欠点としては、以下のようなものがあります:

- ハルシネーション(幻覚/誤情報生成)- 実際には存在しない情報や事実を自信を持って生成してしまう問題です。特に具体的な統計データや引用、人物や出来事の詳細について誤った情報を提示することがあります。

- 知識の時間的制約 – 学習データの時点で知識が制限されており、それ以降の新しい情報や出来事について知ることができません。

- 推論能力の限界 – 複雑な数学的問題や多段階の論理推論が必要な課題では、途中で間違えたり、矛盾した結論に至ることがあります。

- 文脈理解の制約 – 長い会話や複雑な文脈を完全に把握することが難しく、以前の会話内容を忘れたり、一貫性を欠いた応答をすることがあります。

- バイアスの再現 – 学習データに含まれる社会的バイアスや偏見を反映・増幅させてしまう可能性があります。

- 出典の透明性の欠如 – 情報の出所を正確に示すことができず、回答の信頼性を検証することが困難です。

- 多感覚理解の欠如 – テキスト以外の視覚や聴覚などのモダリティを深く理解することに限界があります(マルチモーダルモデルでも完全ではありません)。

- 意図理解の不完全さ – 人間のコミュニケーションに含まれる暗黙の意図や感情的なニュアンスを正確に把握できないことがあります。

- 過剰な自信 – 不確かな情報でも確信を持って回答してしまい、自身の知識の限界を適切に表現できないことがあります。

- 計算リソースの要求 – 高性能なLLMの実行には大量の計算リソースが必要で、エネルギー消費や環境への影響が懸念されています。

これらの欠点は、LLMの利用時に考慮すべき重要な制約となっています。

生成AIが苦手とする仕事

生成AIが苦手とする仕事には、以下のようなものがあります:

- 創造的な問題解決 – 完全に新しい概念やアイデアを生み出す仕事です。AIは既存の情報に基づいて生成するため、真に革新的な発想には限界があります。

- 感情的な判断 – 人間の感情を深く理解し、共感を必要とする仕事(心理カウンセリングなど)では、AIは人間の複雑な感情体験を十分に理解できません。

- 倫理的な決断 – 曖昧な状況での道徳的判断を必要とする仕事は、文脈やニュアンスの理解が必要です。

- 物理的な作業 – ロボット工学の進歩はありますが、繊細な手作業や複雑な物理環境での作業はまだ難しいです。

- 高度な文脈理解 – 文化的背景や暗黙の了解などの微妙なニュアンスを理解する必要がある交渉や外交などの仕事です。

- 完全な信頼性が必要な分野 – 医療や法律など、100%の正確性が求められる分野では、AIの「ハルシネーション」(誤った情報の生成)のリスクがあります。

- 長期的な関係構築 – 信頼関係や人間同士の絆を必要とするリーダーシップやチームビルディングなどの仕事です。

AIは多くの分野で補助ツールとして有用ですが、これらの領域では人間の能力がまだ優位にあります。

今は生成AIの有効な使い方を考えるべき

今は、既に存在している生成AIの欠点を把握した上で、その欠点を人間側が補いながら工夫して使用することが必要です。

その人間側の工夫のノウハウは、まだ試行錯誤が必要な段階にあります。

AIによる技術的失業など考えている暇があるのなら、今ある生成AIをどのように使いこなせば良いのか、ノウハウの開発に精を出す方が、堅実でしょう。

参考までに、Claudeに「LLMの欠点を補い有効活用するには、どのような補助や工夫が必要か」を聞いた回答を載せておきます。

LLMの欠点を補う方法

LLMの欠点を補い有効活用するためには、以下のような補助や工夫が効果的です:

- 人間によるファクトチェック – LLMの出力情報、特に重要な事実や数字は常に検証する習慣をつけましょう。

- 明確な指示(プロンプトエンジニアリング)- 具体的で詳細な指示を与え、曖昧さを減らすことで、より正確な回答を引き出せます。

- 複数の情報源との併用 – LLMの回答だけでなく、信頼できる複数の情報源と照らし合わせて検証します。

- 専門知識を持つ人間の監督 – 特に専門分野では、その分野の専門家がLLMの出力を監督・確認することが重要です。

- リアルタイムデータへのアクセス – 外部のデータベースやAPIと連携させ、最新情報にアクセスできるようにします。

- フィードバックループの構築 – LLMの誤りを報告し、継続的に改善するシステムを整えます。

- 適切なユースケースの選定 – LLMが得意とする分野(文章生成、情報整理など)と苦手な分野(事実確認、複雑な計算など)を理解し、適材適所で活用します。

- 透明性の確保 – LLMが生成した内容であることを明示し、その限界を利用者に伝えます。

- 段階的な検証プロセス – 重要な決定には、LLMの出力を直接使用せず、複数のステップで検証します。

- 目的特化型のファインチューニング – 特定の用途に合わせてモデルを調整することで、精度を高めることができます。

- チェーン・オブ・ソート(CoT)アプローチ – 複雑な問題では、LLMに段階的に考えさせる「思考の連鎖」を促すプロンプトを使用します。

これらの工夫により、LLMの強みを活かしつつ、弱点によるリスクを最小限に抑えることができます。LLMは強力なツールですが、最終的な判断や責任は常に人間側にあることを忘れないことが重要です。

将来の技術の使い方は将来考えれば良い

今存在しないAGIの使い方を、今考えることはできません。

将来AGIが登場するのは確実だとしても、それがどんな製品で、どんな欠点を抱えているのか、現時点では分かりません。

少なくとも、クラウド側で稼働するなら、機械の操作ができない、知識の時間的制約 、長期的な関係構築やリアルタイムでの学習などは、できない可能性があります。

人間の代わりが務まるには、リアルタイムな学習と、それを永続的に記憶しておく仕組み、視覚・聴覚の多感覚理解に、可能ならロボットの身体を有する必要があります。

これらをAGIが実装するのは、不可能とは言いませんが、かなり難しそうです。

実装したとして人間の労働者より安くなるのでしょうか。

数年前まで、自動運転車など2025年ぐらいには実用化するような話が聞こえていましたが、今は自動運転は一部のバスだけで辛うじて試運転をしているだけで、タクシーなどで実用化する見通しは立っていません。

中国からそれらしい情報は来ていますが、かなり信憑性が怪しいと思ってます。

今は、ドローンによる無人宅配すら、まだ実現していません。

AGIのような将来誕生するであろう新技術については、それが登場してから、使い方を考えれば良く、今考える必要は無いでしょう。

そもそも今存在しない技術の使い方を、どうやって考えるのでしょうか。

考える事、将来の心配をすること、それ自体が無駄な仕事です。

今は、教則に進歩する現存の生成AIの使い方だけ考えれば充分でしょう。

ブルシットジョブをわざわざ増やす必要はありません。